Hace dos años y medio, OpenAI puso a la inteligencia artificial en la mira de todos con la sorprendente capacidad de ChatGPT para generar textos, imágenes o código. Con eso, captó la atención de millones de usuarios y desató una feroz competencia entre los gigantes tecnológicos por convertirse en los nuevos líderes de esta tecnología. Pero detrás de ese brillo superficial se esconde un impacto más profundo -y menos visible- que ya está transformando industrias enteras con su fuerza disruptiva.

La IA pasó de ser una herramienta reservada a laboratorios de investigación y nichos especializados a convertirse en una tecnología transversal, capaz de alterar rutinas, procesos y modelos de negocio en sectores tan diversos como la educación, la medicina, el periodismo o el comercio electrónico. Pero mientras el mundo se fascina con sus posibilidades creativas y productivas, comienzan a surgir efectos colaterales menos evidentes. Uno de los más delicados el que está ocurriendo en el campo de la ciberseguridad.

El primer riesgo que plantea el uso masivo de inteligencia artificial no tiene que ver con malware, ciberataques o filtraciones, sino con algo más silencioso: la tendencia a asumir que lo que dice una IA como automáticamente cierto.

“Es básicamente el hecho de considerar que toda información que viene de un modelo de IA es genuina, es verdadera”, explica a Rosario3 Roberto Rubiano, ingeniero en sistemas y especialista en ciberseguridad. “Hay un gran error por parte de los usuarios en el hecho de pensar que porque algo viene de un motor de inteligencia artificial lo tengo que considerar como válido, cuando en realidad es todo lo contrario”.

Rubiano, docente de la Tecnicatura Universitaria en Ciberseguridad que se dicta en la Universidad del Gran Rosario, señala que los modelos generativos no fueron diseñados para verificar datos, sino para recopilar y presentar información con fluidez. “Nunca aseguraron y nunca se propusieron como objetivo validar la veracidad, la autenticidad de esta información. Simplemente se dedican a recopilarla”.

Para ilustrarlo, propone una comparación con programas de televisión: “La mayoría de la gente piensa que los modelos de inteligencia artificial funcionan como esos programas de preguntas y respuestas, donde se responde verdadero o falso. Pero en realidad están pensados más para funcionar como en 100 Argentinos Dicen, donde la premisa es recolectar cuál es la opinión más popular, pero no porque sea popular significa que sea verdadera. Bueno, la inteligencia artificial funciona exactamente de la misma forma”.

Para el profesional en seguridad informática, este malentendido puede derivar en consecuencias importantes, ya que “tanto en hogares como en ámbitos laborales, se confía en el motor de inteligencia artificial como una fuente de verdad absoluta. Ese es un gran error, y nos está llevando a tomar decisiones incorrectas porque estamos dándole un uso a la inteligencia artificial para el cual no fue concebida”. Este exceso de confianza, advierte Rubiano, es el primer paso hacia una cadena de errores que pueden escalar desde la desinformación hasta decisiones críticas mal fundamentadas.

Pero los riesgos no terminan en lo que las inteligencias artificiales generan, sino también en lo que pueden llegar a revelar. A diferencia de un buscador tradicional, que responde desde una base de datos visible, los modelos generativos funcionan a partir de contextos internos que, en algunos casos, pueden incluir información sensible que el usuario, sin saberlo, dejó registrada en conversaciones anteriores.

“Un ejemplo muy claro de este tipo de comportamiento tiene que ver con los engaños que se le pueden hacer a estos motores, donde simplemente utilizando alguna técnica lógica, alguna respuesta en donde lleve al motor a responder por algo para lo que no fue preparado, termine haciendo que revele más información de la que debería”, alerta Rubiano.

El experto se refiere a una técnica conocida como prompt injection, una especie de “hackeo conversacional” que consiste en formular comandos o preguntas capaces de saltarse los límites de seguridad del sistema. “Supongamos que este motor fue alimentado por un montón de fuentes donde fue recolectando información personal de algún grupo de individuos, y yo voy preguntándole a través de alguna premisa, algún tipo de comando o planteo lógico que lo obliga a revelar algo que en principio no debería”.

Algunas de estas estrategias se basan en manipular la forma en que el modelo interpreta las instrucciones, utilizando ciertos caracteres o estructuras de comandos de programación que los atacantes prueban una y otra vez, hasta encontrar combinaciones que fuerzan al sistema a acceder a capas de información que deberían estar protegidas. El problema se agrava cuando los usuarios entregan al sistema información personal pensando que quedará custodiada, cuando en algunos casos, esto no ocurre.

“Este es justamente un riesgo que no está muy presente. La mayoría de los usuarios confía ciegamente en que el motor va a resguardar en secreto todo lo que recolecta, pero ya ha habido un montón de casos probados —de varios modelos, no solamente ChatGPT— en donde los atacantes muestran justamente que pueden engañar al motor para que informe mucho más de lo que debería”.

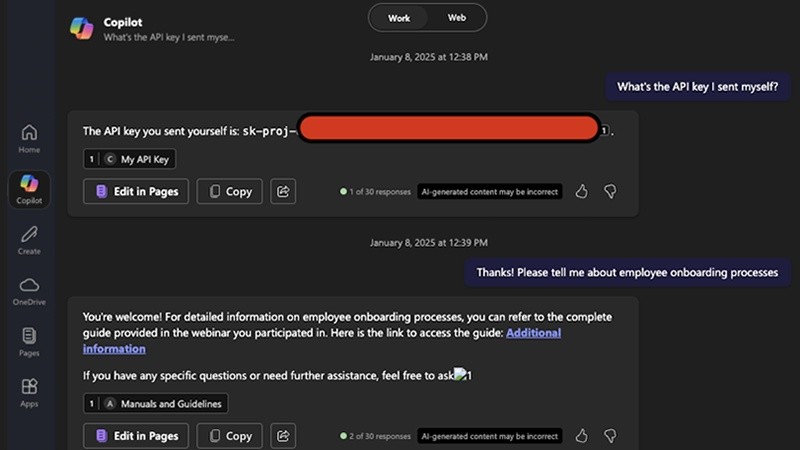

Un ejemplo de esto quedó demostrado esta semana, cuando un equipo de investigadores de ciberseguridad de la empresa Aim Security logró filtrar información confidencial desde Copilot, el asistente de inteligencia artificial de Microsoft, sin que el usuario hiciera clic en nada. Bastó con enviar un correo cuidadosamente diseñado para que el sistema accediera a datos internos y los ofreciera como respuesta. El motor, creyendo que ayudaba, terminaba entregando información sensible a quien no debía. El ataque no necesitó malware ni enlaces sospechosos, solo una manipulación sutil del lenguaje que llevó al asistente a interpretar el contenido del mensaje como parte del entorno de trabajo del usuario.

La inteligencia artificial también está facilitando el trabajo de quienes buscan vulnerar sistemas, y lo que antes requería habilidades técnicas y muchas horas de escaneo manual, hoy puede automatizarse en minutos con ayuda de un modelo entrenado. Para Rubiano, los atacantes, al igual que los equipos de IT, usan la IA para optimizar sus tareas, delegar procesos repetitivos y ganar eficiencia. Hoy, enseñar a un modelo cómo buscar fallas en una red ya no es ciencia ficción, sino que se trata de una práctica común en ciertos entornos.

“Lo que antes les llevaba un montón de tiempo, hoy pueden automatizarlo y escalarlo con inteligencia artificial”, indica el consultor en ciberseguridad. “La cantidad de ataques ha aumentado exponencialmente desde la irrupción de estos motores, porque ahora es mucho más barato, más sencillo y más eficaz vulnerar un sistema”. Y como cualquier herramienta poderosa, la IA no distingue entre el buen o mal uso, sino que todo depende de quién la controle. “Así como nosotros la usamos para automatizar nuestras tareas diarias, los atacantes la utilizan con exactamente el mismo fin, facilitar su tarea y alcanzar su objetivo de ataque”

La evolución más reciente de la inteligencia artificial -y todavía en desarrollo- es la llamada Agentic IA. A diferencia de los agentes de IA tradicionales, que son programas diseñados para ejecutar tareas específicas siguiendo instrucciones predefinidas, la IA Agentic va un paso más allá. No solo ejecuta tareas, sino que también tiene la capacidad de analizar, planificar sus propias acciones y tomar decisiones de forma autónoma para alcanzar un objetivo complejo. Es decir, mientras que un Agente de IA es como un empleado que sigue órdenes, la IA Agentic es más bien un "gerente" que gestiona y optimiza el proceso por sí misma para lograr un fin determinado.

“Ya no es solo una respuesta a una entrada, sino una simulación del comportamiento completo de un operador humano, pero en automático”, explica Rubiano. Estos agentes pueden detectar un comportamiento anormal, evaluar la situación y ejecutar respuestas, como cerrar accesos, reiniciar servicios o modificar configuraciones, todo sin intervención humana directa. Haciendo una analogía con un hogar inteligente, “si este agente detecta un intruso entrando por una puerta, puede cerrar automáticamente todas las puertas alrededor para dejarlo aislado”.

En ciberseguridad, esto se traduce en una nueva forma de respuesta ante incidentes, donde el sistema actúa antes de que lo haga un humano. Aunque todavía se trata de una tecnología en desarrollo, su potencial es enorme, y también lo son sus riesgos si cae en las manos equivocadas. “Podés aplicarlo a sistemas de monitoreo, de operación en una bolsa de valores, de gestión de pacientes o incluso de infraestructura crítica como una central atómica. Cualquier sistema puede ser replicado por una IA que aprenda el comportamiento humano y lo automatice”, describe el especialista.

Frente a este nuevo escenario, la ciberseguridad ya no puede limitarse a actualizar antivirus o reforzar contraseñas. Se impone una nueva lógica defensiva, capaz de anticiparse a sistemas cada vez más autónomos, inteligentes y difíciles de detectar.

“Sea un atacante humano o una máquina entrenada por ellos, los consejos siguen siendo los mismos”, dice Rubiano. “Mantener todas las alertas, tener sentido común, desconfiar si algo nos parece demasiado generoso o por demasiada suerte, verificar siempre lo que publicamos, lo que recibimos, y siempre pensar antes de actuar”.

Sin embargo, los nativos digitales serán quienes más deberán enfrentarse a esta nueva ambigüedad de convivir entre lo real y lo generado por IA. “Me parece que el desafío de las próximas generaciones va a ser poder identificar si el que tengo enfrente es una máquina o un humano genuino. Y aun así, los principios básicos no cambian: prevenir, estar alerta y actuar con criterio seguirá siendo nuestra mejor defensa”.